0

从高层次上讲,注意力机制使神经网络在执行预测任务时可以将注意力集中在输入的相关部分上,而不是无关部分上。

“注意力”就是捕捉我们作为人类所做的事情。例如,如果要手动将一个长的句子从一种语言翻译成另一种语言,那么在任何给定的点上,都要把重点更多地放在要翻译的特定单词或短语上,而不管它在输入句子中的位置。“注意力”为神经网络创建了这种新的机制。

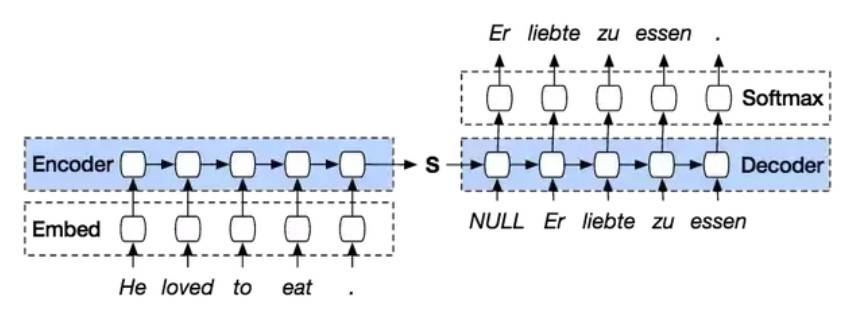

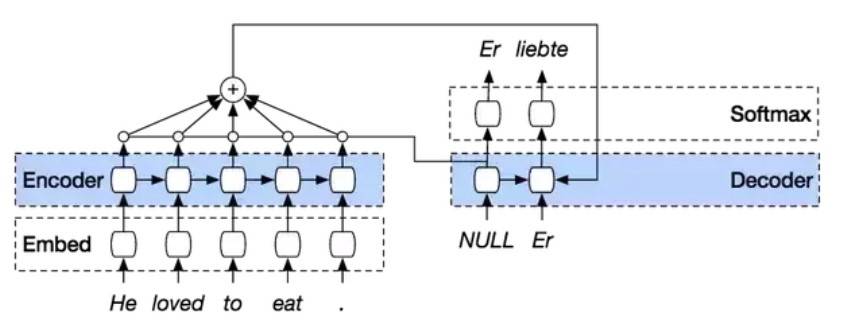

注意机制最常用于序列到序列的模型中。如果没有注意力机制,则模型必须以单个隐藏状态(在下图中以S表示)捕获整个输入序列的本质,但在实践中这很难做到,而且输入序列越长,这个问题就越严重。

注意力机制通过允许在解码器阶段的每个步骤“回头看”输入语句来增强此模型。现在,每个解码器输出不仅取决于最后一个解码器状态,还取决于所有输入状态的加权组合。

考虑到注意力机制所添加的只是网络的其他结构,因此通过反向传播将其作为标准模型训练的一部分进行学习,无需为此做其他任何特殊的事情。

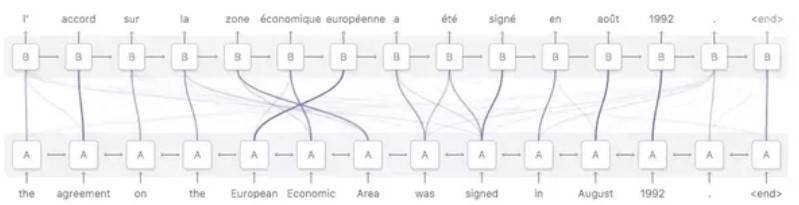

用示例说明,可以考虑从英语到法语的翻译任务,给出最终翻译时,可以看到网络“对应”输入句子的不同部分。

鉴于英语和法语是非常一致的语言,可以看到解码器通常选择顺序翻译为“欧洲经济区”的部分,该短语被翻译为“欧洲经济区”。

收藏

理工酷

理工酷

资源下载

资源下载